Nội dung chính

- 1 Neural Network là gì

- 2 Neural Network giống não người ở điểm nào?

- 3 Neuron hoạt động như thế nào? (đây là cốt lõi của cốt lõi)

- 4 Ví dụ đơn giản để hình dung neuron

- 5 Hàm kích hoạt (activation function) – tại sao cực kỳ quan trọng?

- 6 Neural Network gồm những lớp nào và chúng làm gì?

- 7 Neural Network học như thế nào? (quy trình đầy đủ từ zero → thông minh)

- 8 Một vòng lặp huấn luyện (epoch) gồm những gì?

- 9 Ví dụ cực dễ hiểu: Neural Network phân loại hình ảnh mèo

- 10 Vậy neuron hiểu gì khi nhìn ảnh?

- 11 Mạng sâu (Deep Neural Network) làm gì để mạnh hơn?

- 12 Neural Network trong thực tế: 5 ví dụ cực dễ hình dung

- 13 Neural Network có hạn chế gì?

- 14 Neural Network trong tương lai (2025–2030)

- 15 Tóm tắt bài 4 (cho người bận, nhưng bạn đã đọc hết rồi 😄)

Neural Network — hay Mạng nơ-ron nhân tạo — là nền tảng quan trọng bậc nhất trong Deep Learning. Từ nhận diện khuôn mặt, dịch tự động, ChatGPT, xe tự lái, phân tích ảnh y tế, đến các mô hình dự đoán trong doanh nghiệp… Tất cả đều dựa trên Neural Network.

Nhưng đa số học viên AI chỉ biết “Neural Network giống não người” chứ không thật sự hiểu nó hoạt động thế nào bên trong.

Bài viết này sẽ giúp bạn đi sâu đến mức có thể tưởng tượng được:

-

từng neuron trong mạng tính toán gì

-

dữ liệu đi từ đâu tới đâu

-

vì sao mô hình “biết” phân loại hình ảnh

-

trọng số được cập nhật ra sao

-

tại sao phải có hàm kích hoạt

-

backpropagation chạy thế nào

-

tại sao cần nhiều lớp

-

mô hình học từ sai lầm kiểu gì

Bạn không cần biết toán cao siêu. Mình sẽ giải thích bằng:

-

hình dung trực quan

-

ví dụ thực tế

-

ẩn dụ dễ hiểu

-

quy trình từng bước một

Hãy xem Neural Network thực sự làm gì đằng sau “ánh đèn sân khấu”.

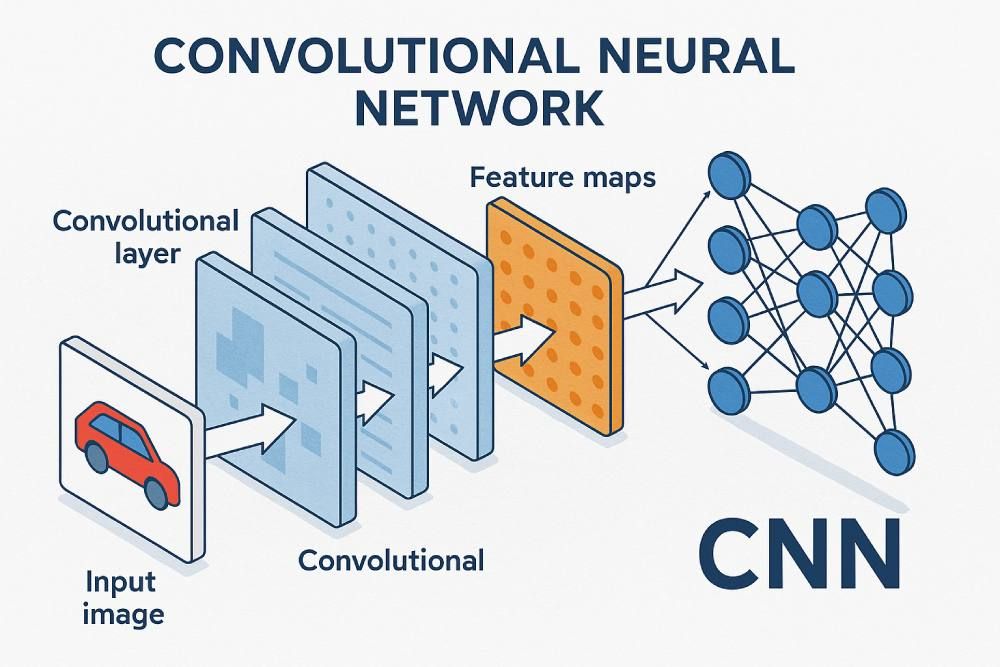

Neural Network là gì

Mạng nơ-ron nhân tạo (Artificial Neural Network — ANN) gồm:

-

neuron (điểm tính toán)

-

liên kết giữa neuron (trọng số – weight)

-

hàm kích hoạt (activation function)

-

các lớp (layers)

Một Neural Network đầy đủ có:

-

lớp đầu vào (input layer)

-

nhiều lớp ẩn (hidden layers)

-

lớp đầu ra (output layer)

Deep Learning = Neural Network có nhiều lớp ẩn.

Mỗi neuron nhận dữ liệu, xử lý, và truyền kết quả sang neuron tiếp theo.

Neural Network giống não người ở điểm nào?

-

Neuron trong não → neuron nhân tạo

-

Kết nối synapse → trọng số

-

Não học bằng lặp lại, sửa sai → mô hình học bằng backpropagation

-

Não càng dùng càng mạnh → mô hình càng huấn luyện càng tốt

Neuron hoạt động như thế nào? (đây là cốt lõi của cốt lõi)

Một neuron nhân tạo thực hiện đúng 3 việc:

-

Nhận input

-

Nhân input với trọng số → tính tổng

-

Đưa tổng đó qua hàm kích hoạt → ra output

Biểu thức:

Trong đó:

-

x = dữ liệu đầu vào

-

w = trọng số (cái mà mô hình học)

-

b = bias (độ lệch, giúp mô hình linh hoạt)

-

activation = hàm phi tuyến giúp mô hình “thông minh” hơn

Ví dụ đơn giản để hình dung neuron

Giả sử neuron nhận 3 dữ liệu:

-

x1 = 2

-

x2 = 1

-

x3 = -3

Mỗi dữ liệu có trọng số:

-

w1 = 0.5

-

w2 = -1

-

w3 = 2

Tính tổng:

Cho qua hàm kích hoạt (ví dụ ReLU):

Neuron này “im lặng”.

Nếu dùng Sigmoid → kết quả ≈ 0.002 → rất nhỏ.

Đó là cách mỗi neuron xử lý input.

Hàm kích hoạt (activation function) – tại sao cực kỳ quan trọng?

Không có activation → mô hình chỉ là phép nhân cộng → dù bạn xếp 100 lớp cũng chỉ là một cái hàm tuyến tính lớn.

Activation giúp mạng:

-

hiểu phi tuyến

-

phân loại đường cong

-

nhận diện hình ảnh phức tạp

-

xử lý giọng nói

-

học ngôn ngữ

Các hàm kích hoạt phổ biến

-

ReLU – nhanh, hiệu quả

-

Sigmoid – cho output từ 0 đến 1

-

Tanh – nhạy hơn Sigmoid

-

Softmax – dùng cho phân loại nhiều lớp

Neural Network gồm những lớp nào và chúng làm gì?

1. Input layer (lớp đầu vào)

Đây là nơi dữ liệu thô đi vào.

-

Ảnh → mỗi pixel trở thành một số

-

Văn bản → chuyển thành token / embedding

-

Bảng dữ liệu → giá trị trong Excel

2. Hidden layers (các lớp ẩn)

Đây là nơi “ma thuật xảy ra”.

Không ai nhìn thấy bên trong, nhưng chính tại đây mô hình:

-

rút trích đặc trưng

-

học quy luật dữ liệu

-

loại bỏ nhiễu

-

nhận diện mẫu

-

tạo nên sự thông minh

3. Output layer (lớp đầu ra)

Cho kết quả cuối:

-

phân loại (mèo/chó)

-

dự đoán giá

-

nhận diện ký tự

-

xác suất 3 loại cảm xúc

-

vector ẩn phục vụ cho mô hình khác

Neural Network học như thế nào? (quy trình đầy đủ từ zero → thông minh)

Đây là phần quan trọng nhất của bài.

Mạng nơ-ron học qua 4 giai đoạn:

1. Forward Propagation – Dòng chảy xuôi

Dữ liệu đi từ đầu vào → qua các lớp → ra đầu ra.

Ở mỗi neuron:

-

nhân input với trọng số

-

cộng bias

-

qua activation

-

gửi output sang lớp tiếp theo

Kết quả cuối là dự đoán.

Ví dụ:

Input: ảnh con mèo → output:

-

0.91 mèo

-

0.07 chó

-

0.02 vật khác

2. So sánh với sự thật (loss function)

Sau khi mô hình dự đoán, ta so với nhãn thật (ground truth).

Ví dụ:

-

mô hình dự đoán “mèo: 0.7”

-

nhãn thật “mèo: 1.0”

Sự khác nhau = loss.

Loss càng nhỏ → mô hình càng đúng.

Loss function giúp biết mô hình sai bao nhiêu.

Ví dụ loss phổ biến:

-

Cross-entropy

-

MSE

-

MAE

3. Backpropagation – Học từ sai lầm

Đây là “trái tim” của Neural Network.

Backprop là quá trình:

-

mô hình tính độ sai (loss)

-

lan ngược lỗi qua từng lớp

-

tìm neuron nào sai nhiều → giảm trọng số

-

tìm neuron nào đúng → tăng trọng số

Nó giống như:

Mỗi lần đoán sai → mô hình tự sửa mình → thông minh lên.

Nếu forward là “đi tới”, thì backprop là “quay lại sửa lỗi”.

4. Update trọng số (Optimizer)

Cuối cùng, các thuật toán tối ưu (optimizer) điều chỉnh trọng số:

-

SGD

-

Adam

-

RMSProp

Adam là phổ biến nhất hiện nay vì:

-

học nhanh

-

ổn định

-

hiệu quả khi dữ liệu lớn

Một vòng lặp huấn luyện (epoch) gồm những gì?

-

Lấy một batch dữ liệu

-

Forward → dự đoán

-

Tính loss

-

Backprop → lan truyền ngược

-

Cập nhật trọng số

-

Lặp lại nhiều lần

Huấn luyện xong → mô hình trở nên “thông minh”.

Ví dụ cực dễ hiểu: Neural Network phân loại hình ảnh mèo

Giả sử bạn đưa 10.000 ảnh mèo và 10.000 ảnh chó cho mạng học.

Lần đầu tiên mô hình dự đoán:

-

Ảnh mèo → đoán chó

-

Ảnh chó → đoán mèo

-

Sai gần hết

Trọng số lúc này là ngẫu nhiên, nên mô hình như:

“Tôi mù màu, tôi chưa biết gì.”

Sau vài vòng học:

-

mô hình bắt đầu nhận ra cạnh ảnh

-

phát hiện mắt, mũi, tai

-

phân biệt lông

-

hiểu mèo có mặt tròn

-

chó có mõm dài hơn

Sau nhiều vòng học:

-

accuracy: 95% – 99%

Mô hình đã hiểu “mèo” là gì.

Không ai phải dạy từng quy tắc.

Tất cả là nhờ backprop.

Vậy neuron hiểu gì khi nhìn ảnh?

Neural Network học “từ đơn giản đến phức tạp”:

Lớp đầu học:

-

cạnh

-

đường cong

-

góc

Lớp giữa học:

-

mắt

-

mũi

-

tai

Lớp cao học:

-

toàn bộ khuôn mặt

-

hình dáng tổng thể

-

đặc trưng mèo vs chó

Neural Network xây dựng khái niệm giống cách con người học:

Từ nét → bộ phận → vật thể.

Mạng sâu (Deep Neural Network) làm gì để mạnh hơn?

Càng nhiều lớp → mô hình càng “hiểu sâu”.

-

3 lớp: hiểu cạnh

-

10 lớp: hiểu bộ phận

-

50 lớp: hiểu hình ảnh phức tạp

-

1000 lớp: hiểu nội dung ngữ nghĩa

Deep Learning mạnh hơn ML truyền thống vì:

-

tự học đặc trưng

-

khả năng biểu diễn cực cao

-

hiểu các cấu trúc phi tuyến rất phức tạp

Neural Network trong thực tế: 5 ví dụ cực dễ hình dung

1. Nhận diện khuôn mặt (Facebook, iPhone)

Mạng 200+ lớp phân tích:

-

vị trí mắt

-

độ cong cằm

-

khoảng cách giữa các đặc trưng

-

hình dạng môi

Cuối cùng xuất ra vector khuôn mặt (embedding).

So sánh vector này với các vector trong database để tìm người.

2. AI tạo ảnh như Midjourney

Sử dụng:

-

CNN

-

Transformer

-

Diffusion Models

Mỗi pixel được “dự đoán” lại nhiều lần để tạo hình ảnh.

3. ChatGPT – hiểu ngôn ngữ

Transformer là Neural Network:

-

có attention

-

có 70–200+ lớp

-

hàng trăm tỉ tham số

Nó hiểu văn bản bằng cách:

-

mã hóa từ

-

học ngữ cảnh

-

dự đoán từ tiếp theo

4. Xe tự lái

Mô hình DL phân tích:

-

lane đường

-

vật thể

-

khoảng cách

-

tốc độ

-

nhận diện biển báo

Neural Network đưa ra quyết định lái xe.

5. Y tế – phát hiện ung thư

CNN + Transformer giúp:

-

phát hiện khối u nhỏ

-

phân biệt mô bất thường

-

đo kích thước tổn thương

Độ chính xác có thể ngang/better bác sĩ.

Neural Network có hạn chế gì?

Không có gì hoàn hảo. Neural Network cũng vậy.

1. Cần rất nhiều dữ liệu

Thiếu dữ liệu → mô hình ngu.

2. Cần GPU đắt

Huấn luyện tốn tài nguyên.

3. Khó giải thích

“Black box” — khó biết tại sao mô hình lại đưa ra quyết định.

4. Dễ bị overfitting

Học quá kỹ → không áp dụng được dữ liệu mới.

5. Không phù hợp với dữ liệu nhỏ

ML truyền thống đôi khi tốt hơn.

Neural Network trong tương lai (2025–2030)

5 xu hướng:

1. Mô hình đa phương thức

Xử lý text + ảnh + âm thanh + video cùng lúc.

2. AI chạy trên thiết bị nhỏ

Neural Network tối ưu chạy trên điện thoại, IoT.

3. Mô hình nhỏ nhưng mạnh

LLM compact (Mini-GPT), MobileNet, TinyML.

4. Mạng có khả năng “tự học” không cần nhiều dữ liệu

Meta Learning + Few-shot Learning.

5. Neuro-Symbolic AI

Kết hợp NN + quy tắc logic → chính xác hơn, giải thích tốt hơn.

Tóm tắt bài 4 (cho người bận, nhưng bạn đã đọc hết rồi 😄)

-

Neural Network gồm neuron, trọng số, hàm kích hoạt

-

Neuron = phép nhân + cộng + activation

-

Mạng có input → hidden → output

-

Học bằng:

-

forward

-

tính loss

-

backprop

-

update trọng số

-

-

Deep Learning = nhiều lớp → học đặc trưng tự động

-

Ứng dụng vô hạn: ảnh, video, âm thanh, ngôn ngữ, xe tự lái

-

Thách thức: dữ liệu lớn, GPU mạnh, khó giải thích

Series 5 bài viết tổng quan về AI cho người mới hoàn toàn

(Bài 1) Trí Tuệ Nhân Tạo (AI) Là Gì? – Kiến thức dành cho người mới

(Bài 2) Machine Learning là gì?

Be the first to comment